競合企業の動向や最新の流行をタイムリーに理解することは、マーケティング活動において重要です。情報を大量に手作業で収集すると、膨大な時間がかかります。そのため、効率的な情報収集にはスクレイピングツールの使用が有効です。そこで今回は、スクレイピングツールのおすすめ10選、導入メリット・デメリットと選び方を解説します。

目次

スクレイピングツールとは?

スクレイピングツールとは、Webサイトのデータを自動的に収集し、目的に合わせて加工するツールのことです。スクレイピング技術を利用することで、市場分析に欠かせない情報を正確かつ大規模に集めることができます。過去の経験則や直感に頼ることなく、実証データに基づくデータ駆動型のマーケティング施策や販売戦略を進められるでしょう。

スクレイピングツールの活用例

スクレイピングツールの活用例には、主に以下の3つがあります。

- マーケティング

- Webサイト運営

- 株価の情報収集

それぞれについて、詳しく解説していきます。

マーケティング

スクレイピングツールの活用例の1つ目は、マーケティングです。競争の激しいビジネス環境において、企業が市場のトレンドや消費者のニーズをリアルタイムで把握し、迅速に判断するうえでスクレイピングツールの利用は有効です。スクレイピングツールでは、競合他社のWebサイトやSNSから、製品の価格・キャンペーン情報・顧客のレビューなどを自動で収集し、分析できます。また、スクレイピングで得た情報は、製品開発やサービスの改善にも役立てることができ、顧客満足度の向上にも役立ちます。スクレイピングツールを用いることで市場の変動に敏感に反応し、データに基づいた戦略的な意思決定を行えるでしょう。

関連記事:市場調査とは?メリットと主な方法・おすすめツール6選の比較まで徹底解説

Webサイト運営

スクレイピングツールの活用例の2つ目は、Webサイト運営です。運営者は自身のサイトや競合サイトからのコンテンツ、ユーザーの行動パターン、SEOキーワード、広告表示の効果など、多様なデータを効率的に収集できます。特に、SEO戦略の策定においては、競合サイトのキーワードや被リンク情報を分析し、自サイトのコンテンツ改善や検索エンジンでの順位向上に役立てることは有効です。また、スクレイピングツールで得た情報を分析することは、ユーザー体験の向上にも貢献します。ユーザーがどのようなコンテンツに関心を持っているか、どのページで離脱する傾向にあるかなどの情報を基にサイト設計の最適化を行うことで、訪問者の滞在時間の延長やコンバージョン率の向上が見込めるでしょう。

株価の情報収集

スクレイピングツールの活用例の3つ目は、株価の情報収集です。スクレイピングツールを用いることで、リアルタイムでの株価変動、歴史的な価格データ、各種指標、企業の財務報告書などの重要な情報を幅広いソースから自動的に収集し、分析することが可能になります。収集したデータは、市場のトレンド分析、ポートフォリオのリスク管理、投資機会の識別に役立ちます。また、データを基にアルゴリズムトレーディング戦略を構築したり、より高度な市場予測モデルを開発することも可能です。スクレイピングツールは、金融市場における情報収集と分析を効率化し、投資戦略の質を向上させる重要な役割を果たします。

スクレイピングツールの導入メリット

スクレイピングツールの導入メリットには、主に以下の3つがあります。

- データ収集にかかる時間を削減できる

- APIでは得られない情報を取得できる

- 大量のデータを活用できる

それぞれについて、詳しく解説していきます。

データ収集にかかる時間を削減できる

スクレイピングツールを導入することで、業務プロセスを自動化し、データの収集にかかる時間や労力を削減できます。データ収集が複雑で広範囲にわたる場合、作業時間の消費と負担は増大し、過労や長時間労働のリスクが生じることもあります。そこで、スクレイピングツールでデータ関連の作業を部分的に自動化することで、社員の業務負担軽減が見込めます。社員がより重要な作業に時間を確保できるようになるでしょう。

APIでは得られない情報を取得できる

スクレイピングツールを活用すれば、APIを通じてアクセスできない情報も収集可能です。APIを使用した場合、特定のソフトウェアやアプリの機能を外部開発者に開放していますが、情報や機能を利用するには提供元の許可が必要です。一方で、スクレイピングツールを用いれば、情報提供者の許諾を取らずに、幅広いデータを収集できます。より詳細な情報を得られることで、ニーズに応じたデータ活用が実現するでしょう。

大量のデータを活用できる

スクレイピングツールの使用により、広範囲のデータ活用が可能になります。マーケティングや製品開発などの分野では、内部データの活用は欠かせませんが、利用可能なデータの量に限りがあると、期待する成果や分析が困難になることがあります。そこで、スクレイピングにより外部データの収集範囲を拡大すれば、消費者の要望を深く理解し、データに基づいたビジネス展開やサービス提供のチャンスが見込めるでしょう。

スクレイピングツールの導入デメリット

スクレイピングツールの導入デメリットには、主に以下の3つがあります。

- システム障害を起こす可能性がある

- 著作権を遵守する必要がある

- 情報漏えいのリスクがある

それぞれについて、詳しく解説していきます。

システム障害を起こす可能性がある

スクレイピングツールの使用により、手作業では実現できないほど多くのアクセスが可能になります。ただし、過剰なアクセスは相手側のサーバーに負荷をかけてしまうため、システムの不具合やダウンのリスクを招くことがあります。

著作権を遵守する必要がある

著作権法では個人使用目的のコピーまたはデータ分析のためのコピーが許可されていますが、Webサイトによっては使用条件でスクレイピングを禁じている場合があります。使用条件に違反してスクレイピングを実施すると、法的な問題を引き起こす可能性があるため、遵守することが大切です。

情報漏えいのリスクがある

スクレイピングツールを利用するときは、セキュリティの確認も必須です。スクレイピングツールはログイン情報を要求するWebサイトにアクセスする場合、ユーザー名やパスワードを入力し認証を受けます。ただし、提供したログイン情報がWebサイトの管理者によって不正利用されることがあり、情報漏えいにつながるリスクがあります。特に、個人データを渡す場合は、Webサイトの背景や信頼性をしっかりと調べ、安全性が保証されていると確認できた情報を使用することをおすすめします。スクレイピングはデータ収集を効率化する便利なツールですが、使用するときにはセキュリティ意識を持って使用することが大切です。

スクレイピングツールの選び方

スクレイピングツールを選ぶときには、以下の3つのポイントを押さえましょう。

- 法令チェックを行っているか

- 導入は容易に行えるか

- 運用のサポートは受けられるか

それぞれについて、詳しく解説していきます。

法令チェックを行っているか

スクレイピングの実施には法的なリスクが伴うことがあるため、導入予定のツールが法的な問題を抱えていないか検証することが大切です。違法行為を避けるには、法律顧問を配置し、法的規制の遵守を定期的に確認しているサービス提供者を選択しましょう。

導入は容易に行えるか

一部のツールではプログラミングが前提となっているため、プログラミングスキルに自信がなければ、直感的な操作で使用できるツールの選択をおすすめします。開発業務を外部のエンジニアに委託することも可能ですが、その場合、エンジニアの協力が必要となり、プロジェクトの進行速度に影響を及ぼすことがあります。また、外部のエンジニアに開発を依頼した場合も、プロジェクトの引き継ぎ時にトラブルが発生する可能性があることを考慮する必要があるでしょう。

運用のサポートは受けられるか

スクレイピングツールを業務に取り入れるには、一定の知識と実践経験が求められます。データ抽出の基準などを正しく設定できず、ツールをうまく活用できないことも少なくありません。そのためツールの導入前には、ベンダーからどの程度の運用サポートが得られるかを確認しておきましょう。

スクレイピングツールのおすすめ10選を比較

ここでは、スクレイピングツールのおすすめ10選を紹介します。

- Octoparse

- ParseHub

- Crawly

- Sequentum

- Import.Io

- WebHarvy

- Dexi.io

- Outwit Hub

- 80legs

- Common Crawl

それぞれの特徴を、詳しく解説していきます。

Octoparse

Octoparseは、コーディング不要で使用できるスクレイピングツールです。数回クリックするだけという簡単な操作で、Webページから自動的に構造化データを抽出できます。24時間365日稼働するクラウドベースの自動化機能が備えられていることも魅力です。効率的に大量のデータを収集・エクスポートできるため、データ収集の時間と労力を削減できるでしょう。

Octoparseの特徴

- プログラミング不要で誰でも簡単に使用可能

- AIを活用したスマートなデータ検出

- クラウドベースの高度な自動化機能

URL: https://www.octoparse.jp/

ParseHub

ParseHubは、使いやすさを重視した無料のスクレイピングツールです。必要なデータをクリックするだけで簡単に抽出できます。JavaScriptやAJAXを使用した複雑なサイトからも、フォーム検索やドロップダウンの開閉などを介してデータをスクレイプできるため、大量の情報収集が実現します。収集したデータはExcelやAPI経由のデータに出力できるため、活用しやすい点も魅力です。

ParseHubの特徴

- 直感的な操作で簡単にデータ抽出が可能

- JavaScriptやAJAXページにも対応

- Excelでのデータ出力が可能

URL: https://www.parsehub.com/

Crawly

Crawlyは、Webサイトを数秒でデータ化するスクレイピングツールです。コード不要で使用でき、WebサイトのURLを入力するだけでCrawlyがそのサイトをクロールし、構造化されたデータを自動的に抽出します。記事の内容から必要な情報を取り出すことができるため、データ収集にかかる時間の削減が期待できます。大量のデータ抽出が必要な研究者・マーケター・データアナリストに選ばれているツールです。

Crawlyの特徴

- URLを入力するだけで全サイトのデータを抽出可能

- コーディング知識不要で導入が容易

- 自動で構造化データを抽出

URL: https://crawly.diffbot.com/

Sequentum

Sequentumは、エンタープライズサーチ専用のデータ提供プラットフォームです。エンタープライズにある大量のデータ収集が自動で行えるため、工数の削減やコスト削減が見込めます。簡単なポイント&クリックの操作で使用できますが、プログラミングを組み込むことも可能です。クラウドベースとオンプレミスから選択でき、自社にあった方を選択できるのも魅力です。

Sequentumの特徴

- コードが少なくデータパイプラインを構築可能

- インフラコストを削減して経済的に使用できる

- データコンプライアンスにも配慮

URL: https://www.sequentum.com/

Import.Io

Import.ioは、プログラミング不要のWebデータ抽出サービスです。情報を取得したいWebサイトのURLを入力するだけでデータを収集できる、クラウド型のサービスです。直感的なポイント&クリック操作で、ページ内の特定の情報やデータフィールドを簡単に選択できます。APIやストリーミングAPIを通じてリアルタイムでデータにアクセスできるため、さまざまなプログラミング言語やデータツールとの統合も容易に行えるでしょう。

Import.Ioの特徴

- 市場情報に基づく戦略的意思決定のサポート

- 幅広い業界に対応したカスタムソリューション

- データ収集にかかる時間を削減できる

WebHarvy

WebHarvyは、コーディング知識がなくても直感的に操作できるビジュアルスクレイピングソフトです。ポイント&クリックの簡単な操作で、テキスト・HTML・画像・URL・メールなど、あらゆるWebサイトからデータを簡単に抽出し、複数の形式で保存することが可能です。プロキシサーバーやVPNを利用して、匿名性を保ちながらデータを収集できるため、セキュリティ対策も講じられています。

WebHarvyの特徴

- コーディング不要で直感操作

- 画像・HTMLデータも収集可能

- プロキシ・VPNでの匿名スクレイピング

URL: https://www.webharvy.com/

Dexi.io

Dexi.ioは、Webサイトからのデータ抽出を通じて、信頼性の高いデータソースを提供するツールです。旅行・価格設定・製品在庫・顧客感情など、多岐にわたる情報を構造化データとして抽出し、分析やビジネス戦略の構築に活用できます。ユーザーフレンドリーなインターフェースと柔軟なカスタマイズオプションにより、特定のニーズに合わせたデータ収集が簡単に行えることも魅力です。

Dexi.ioの特徴

- 多岐にわたる情報を構造化データとして抽出

- 独自技術によりエンドツーエンドに対応

- 柔軟なカスタマイズでKPIを推進

URL: https://www.dexi.io/

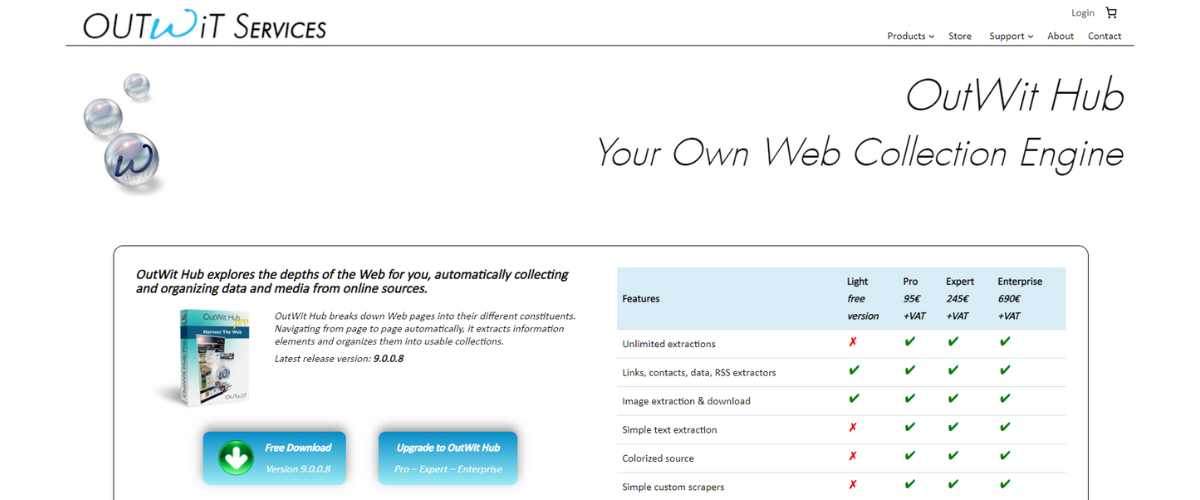

Outwit Hub

Outwit Hubは、Firefoxのアドオンストアから手軽にダウンロードできるFirefoxの拡張機能です。プログラミングの知識がなくても使用でき、RSSフィード・データテーブルなどさまざまなデータを抽出し、Excel・CSV・HTML・SQLデータに変換できます。また、指定したURLリストから迅速にデータをスクレイピングできるのも特筆すべき点です。

Outwit Hubの特徴

- プログラミング不要で直感的に操作可能

- 幅広いデータ形式でのエクスポート対応

- 高度なフィルタリングとデータ管理機能

URL: https://www.outwit.com/products/hub/outwit-hub-light-pro-expert-enterprise-editions/

80legs

80legsは、クラウドベースのスクレイピングツールです。Web全体をクロールして独自のデータを抽出する機能を備えているため、広範囲のデータを収集できます。大量のデータ収集が必要な研究者、マーケター、データアナリストなどにとっては、データ収集の効率化と簡素化の実現に役立つツールといえるでしょう。

80legsの特徴

- クラウドベースでどこからでもアクセス可能

- Web全体のクローリングで広範なデータ収集

- 即座にWebデータへのアクセスを実現

URL: https://80legs.com/

Common Crawl

Common Crawlは、17年にわたりオープンWebデータの大量抽出、変換、分析を支援し、研究者に提供しているスクレイピングツールです。累計で2,500億ページ以上のデータを扱ったという、膨大な情報源を提供した実績があります。データ駆動型の研究を行う研究者や学生、教授におすすめのツールです。

Common Crawlの特徴

- 17年以上の実績を持つ大規模データベース

- 毎月数十億ページを新たに追加

- 学術研究で広く引用される信頼性

まとめ

今回は、スクレイピングツールのおすすめ10選、導入メリット・デメリットと選び方を解説しました。スクレイピングツールを使えば、APIでは得られない情報などを収集でき、活用しやすいデータ形式に抽出できます。一方で、情報漏えいのリスクや法的なリスクがあるため、信頼できるツールを選ぶことが大切です。導入や運用のサポートなどにも着目して、自社にあったサービスを選びましょう。

関連記事:【2024年版】情報収集アプリおすすめ6選を徹底比較!メリット・注意点・選び方まで詳しく解説

NotePM(ノートピーエム) は、Webで簡単にマニュアル作成できて、強力な検索機能でほしい情報をすぐに見つけられるサービスです。さまざまな業界業種に導入されている人気サービスで、大手IT製品レビューサイトでは、とくに『使いやすいさ・導入しやすさ』を高く評価されています。

NotePMの特徴

- マニュアル作成、バージョン管理、社外メンバー共有

- 強力な検索機能。PDFやExcelの中身も全文検索

- 社内FAQ・質問箱・社内ポータルとしても活用できる

- 銀行、大学も導入している高度なセキュリティ。安全に情報共有できる

URL: https://notepm.jp/